Editori:

Ricerca finanziata dal MURST Dipartimento per gli Affari Economici Ufficio III, Programmi di Ricerca di Rilevante Interesse Nazionale nell'ambito del Progetto n.9909112115 "Gestione Integrata di Sistemi Produttivi Interagenti: Metodi Quantitativi Avanzati per la Quick Response", Area 09 - Ingegneria industriale, 1999.

Stampato a Genova, Italy, November 2001

ISBN 88-900732-0-9

Editori:

Agostino Bruzzone, Roberto Mosca, Roberto Revetria

DIP University of Genoa

Via Opera Pia 15

16145 Genova, Italy

[email protected], [email protected], [email protected]

Report Finale: Gestione Integrata di Sistemi Produttivi Interagenti: Metodi Quantitativi Avanzati per la Quick Response

Coordinatore Scientifico del Programma di Ricerca:

Roberto Mosca, DIP, Universita’ di Genova

Responsabili Scientifici delle Altre Sedi Consorziate:

Martino Bandelloni, SITI DE, Universita' Firenze

Gino Cardarelli, DE, Universita' dell’Aquila

Marco Garetti, DIG (ex-DEP), Politecnico di Milano

Alfredo Lambiase, DIMEC, Universita' di Salerno

Marcello Lando, DIMEG, Universita' di Napoli, Federico II

Giovanni Mummolo, DIMEG (ex-DPPI), Politecnico Bari

Permission is granted to photocopy portions of the pubblication for personal use and for the use of students providing credit is given to the MURST Project n.9909112115 "Gestione Integrata di Sistemi Produttivi Interagenti: Metodi Quantitativi Avanzati per la Quick Response", Roberto Mosca. Permission does not extend to other type of reproduction nor to copying for incorporation into commercial advertising nor for any other profit-making purpose. Other publications are encouraged to include 300 to 500 word abstracts or summaries for any chapter included in this book providing credit to the author and to the MURST Project n.9909112115 "Gestione Integrata di Sistemi Produttivi Interagenti: Metodi Quantitativi Avanzati per la Quick Response" Roberto Mosca

Obiettivo di questo progetto è stato la costruzione di reti di simulatori gerarchici interagenti on line per la quale, in base all'esperienza acquisita nel lavoro effettuato dal gruppo genovese del DIP, il programma della ricerca si e’ articolato in tre fasi principali:

Costruzione di schedulatori e di shell di simulatori in grado di consentire lo studio di una ampia casistica di impianti di produzione nel settore manifatturiero mediante riconfigurazioni snelle e amicali ma anche con interfaccia friendly nei confronti dell'utente finale.

Scelta del protocollo ottimale di colloquio tra i differenti livelli gerarchici sulla base di considerazioni sia di tipo teorico (tecnologia, economicità, rapporto prezzo/prestazione, affidabilità, etc.) che sperimentale.

Convalida della metodologia mediante applicazione ad un caso reale significativo (almeno tre livelli gerarchici)

Nella fase iniziale, della durata di 12 mesi, sono stati chiamati a partecipare tutti i gruppi di ricerca, con le loro competenze e abilità specifiche, maturate in passato, nell'affrontare il problema della programmazione multi-site e ora quello della gestione integrata del rapporto main-subcontractor.

In questa fase Genova ha provveduto a generalizzare maggiormente, con l'aggiunta di nuovi elementi e di nuove logiche, la shell OSIRIS operando a stretto contatto con il gruppo di Bari (simulatori ibridi) e con il gruppo di Firenze (costruzione automatica di modelli di simulazione).

Alla sede di Napoli è stato demandato lo studio del problema delle assegnazioni più convenienti delle diverse attività di sub-fornitura nell'ottica di massimizzazione dell'efficienza globale del sistema di produzione in presenza di più fornitori con profili diversi in termini di qualità, costo del prodotto, rispetto dei termini di consegna, etc., mentre a quello di Salerno è stato assegnato l'obiettivo di studiare i problemi di interfacciamento tra simulatori e metodologie ERP.

Le sedi di Milano e dell'Aquila infine hanno avuto il compito di studiare tipologie di schedulazioni innovative, da abbinare ai simulatori.

Nella seconda fase, della durata di 6 mesi si sono valutate possibili soluzioni alternative anche mediante sperimentazione diretta attraverso l'aiuto di aziende e di altri gruppi di ricerca con i quali esistono rapporti di collaborazione (es. Riga TU).

Lo fase finale, durata circa 1 anno, con tutti i gruppi contemporaneamente impegnati, e’ stata prettamente sperimentale: in esso e’ stata individuata una azienda tipo ed e’ stata modellizzata.

L’esperienza del progetto ha consentito di evidenziare le necessità di coordinamento e gestione di progetto che sono risultate una componente chiave per arrivare a completare con successo il corrente programma di rircerca. Sotto questo profilo al ruolo del coordinatore scientifico e’ stato affiancato quello di responsabile del progetto per quanto riguarda modellizzazione ed integrazione al fine di garantire un efficace sviluppo della ricerca.

La buona volonta’ dimostrata da tutti i partecipanti al progetto, nonche’ lo spirito di iniziativa emerso durante le diverse fasi hanno dimostrato come obiettivi ambiziosi quali quelli all’origine della ricerca fossero comunque pienamente raggiungibili.

L’innovativita’ legata all’impiego di tecnologie nuove e praticamente inesplorate nello specifico settore industriale e infrastrutturale, non solo ha consentito di ottenere risultati prestigiosi a livello internazionale, ma ha anche fornito uno spunto a tutti i partecipanti per mettere a frutto il meglio delle loro esperienze e tutta la loro professionalita’.

Il completamento del progetto non va considerato un punto d’arrivo dato che tutti i partners coinvolti sono attualmente attivi in una prosecuzione di detta ricerca (progetto WILD Web Integrated Logistics Designer) destinato a sfruttare non solo questa esperienza, ma anche gli strumenti e le metodologie messe a punto, per studiare tecniche innovative di pianificazione distribuita della supply chain.

Per i contenuti relativi al gruppo di ricerca DIP Genova gli autori risultano essere Agostino Buzzone, Pietro Giribone, Roberto Mosca, Roberto Revetria, Flavio Tonelli.

Per i contenuti relativi al gruppo di ricerca DE L’Aquila, gli autori ed i curatori risultano Gino Cardarelli, Antonio Caputo e Gabriele Di Stefano.

Per i contenuti relativi al gruppo di ricerca DIG (ex DEP) Milano gli autori risultano essere Marco Garetti, Alberto Portioli, Sergio Cavalieri, Roberto Cigolini, Maria Caridi, Alessandro Brun, Marco Macchi, Sergio Terzi.

Per i contenuti relativi al gruppo di ricerca DIMEC Salerno, gli autori ed i curatori risultano essere Raffaele Iannone e Alfredo Lambiase, Salvatore Miranda, Stefano Riemma.

Per i contenuti relativi al gruppo di ricerca DIMEG (ex DPPI) Bari gli autori risultano essere Giovanni Mummolo, Raffaello Iavagnilio, Giorgio Mossa, Maria Grazia Gnoni, Ornella Benedettini, Ranieri.

Per i contenuti relativi al gruppo di ricerca DPGI Napoli, gli autori ed i curatori risultano essere Elisa Andrei, Marcello Lando, Roberto Macchiaroli, Maria Elena Nenni, Liberatina Santillo, Matteo Savino.

Per i contenuti relativi al gruppo di ricerca SITI DE

Firenze, gli autori ed i curatori risultano Mario Rapaccini, Mario Tucci

e Gianni Bettini.

Si desidera ringraziare per il contributo fornito il MURST e le Sedi cofinanziatrici (Politecnico di Bari, Politecnico di Milano, Università di L’Aquila, Università di Firenze, Università di Genova, Università di Salerno, Università Federico II di Napoli) del Project n.9909112115 "Gestione Integrata di Sistemi Produttivi Interagenti: Metodi Avanzati per la Quick Response". Un ringraziamento va a tutti i soggetti coinvolti nel suddetto progetto:A.Giannocoli, M.Loi, R.Vulcano, M.Schenone, A.Bonello, S.Pozzicotto, O.Chiambretti, A.Brandolese, A.Pozzetti, A.Sianesi, M.Taisch, P.Mancino, M. Ferretti, A.Cardamone, A.Autorino, R.Rizzo, A.Valentino, V.Zoppoli, M.Palumbo, P.Pelagagge, R.Rinaldi, M.Bandelloni.

Un ringraziamento speciale va alla compagine industriale che ha fornito il caso per la sperimentazione e la dimostrazione, indispensabile per la convalida delle teorie e delle metodologie proposte nella ricerca; in particolare si ringrazia la Piaggio Aero Industries e tutte le industrie coinvolte nella sperimentazione per la disponibilità dimostrata: Geven, Magnaghi, OMA, PlyForm, Salver, Sirio Panel.

Un particolare ringraziamento a Giorgio Garassino che ha fornito un supporto fondamentale quale subject matter expert nella convalida del modello e punto di contatto per la fase di dimostrazione.

Ringraziamo particolarmente per il contributo significativo in sede di sviluppo e sperimentazione Giorgio Vigano' e Giorgio Diglio.

Si ringraziano, inoltre, per l’aiuto offerto negli sviluppi della sede di Firenze: Elisabetta De Sabato, Massimiliano Mestrone, Manuele Cheli, Matteo Maurri, Nunzio Martino e Jacopo Pancani. Si ringrazia inoltre Ernesto Ippoliti per il contributo offerto nella sede di L'Aquila e Marco Baldoli per il contributo offerto nella sede di Salerno.

Un ringraziamento significativo per il supporto nella formazione relativa all'architettura HLA va riconosciuto a: R.Crosbie, K.Morse, E.M.Mantero, T.McGuire, S.Simeoni. Ringraziamo inoltre i colleghi che in altre sedi internazionali hanno collaborato con il presente progetto e con cui e' stato possibile corrispondere proficuamente per lo sviluppo di dette linee di ricerca: P.Elfrey, C.Frydman, N.Giambiasi,R.Huntsinger, Y.Merkuryev, A.Naamane, G.Neumann, M.Schumann, T.Schultze, R.Signorile, O.R.Torinco, G.Upkenis, E.Williams.

Per la parte di supporto web e design si ringraziano G.Berrino, M.Mosca, L. Patrone.

Un ultimo sentito ringraziamento va al compianto Franco

Turco che spentosi nel corso del progetto a seguito di una terribile malattia,

ha comunque corrisposto un significativo contributo e funge tutt'oggi da

ispiratore a molte iniziative fra tutti colleghi del progetto.

Gestione Integrata di Sistemi Produttivi Interagenti: Metodi Quantitativi Avanzati per la Quick Response

COMPENDIUM

Giovan Battista Perasso

Gestione Integrata di Sistemi Produttivi Interagenti: Metodi Quantiativi Avanzati per la Quick Response

Costruzione Schedulatori User Friendly per ampia gamma di casi manufatturieri

DIP, Genova

Obiettivo primario della ricerca condotta è stata la creazione di uno strumento innovativo per la gestione integrata on-line/real-time della produzione di unità operative distribuite,nell'imprenscindibile ottica della quick response, e con particolare riferimento alla sempre più diffusa pratica dell'outsourcing, pratica attuata in special modo da aziende di grandi dimensioni verso le piccole medie imprese (utilizzando per questi termini la classificazione UE su dipendenti e fatturato) e quindi di basilare interesse per quella miriade di aziende che costituiscono l'asse portante del tessuto industriale nazionale.

Risulta opportuno, per una migliore comprensione della proposta di ricerca attuale, ricordare che il "core" del ricercatore impiantista è rappresentato non dallo studio di questo o di quel componente, ma dell'impianto nella sua globalità, sia come progetto che come gestione, conformemente ai dettami della visione sistemica dell'azienda in generale e della sua produzione in particolare.

Per raggiungere gli scopi della "mission" l'impiantista utilizza talora le metodologie create da specialisti puntuali di altre discipline (dalle macchine alla ricerca operativa, dall'informatica alla fisica tecnica, etc.) per finalizzarle all'indagine comportamentale e alla creazione di regole gestionali per quel sistema, sempre ad elevata complessità, che viene genericamente definito "impianto", nell'intento di ottimizzarne la progettazione, la gestione, la manutenzione, i trasporti interni, la produzione, etc.

Pertanto se è pur vero che talora le metodologie utilizzate possono essere non di frontiera, se giudicate da chi le ha ideate e le realizza, le applicazioni che di esse ne fa l'impiantistica sono sicuramente originali, come si conviene alla ricerca applicata, e di sicura validità tecnica, scientifica ed economica.

Tornano all'obiettivo della riecrca, in termini metodologici, esso e’ stato perseguito attraverso la creazione di network di simulatori / schedulatori gerarchicamente interagenti e attivati on line / real time al controllo della produzione.

Ogni simulatore di livello gerarchicamente inferiore (sub fornitori) e’ in grado di ricevere ed elaborare le informazioni di sua competenza relative a variazioni nella programmazione della produzione al livello superiore.

Sulla base di queste lo strumento locale di simulazione / schedulazione provvede alla riprogrammazione della produzione dell'unità interessata. Riprogrammazione che, poi, e’ sottoposta, assieme a quella di altri sub fornitori di pari livello gerarchico, al simulatore posto al livello immediatamente superiore.

Quest'ultimo, sulla base dei risultati ottenuti a seguito del loop di schedulazione / simulazione, vaglia l'accettabilità delle soluzioni proposte, rinviando al livello inferiore eventuali richieste di riprogrammazione.

Obiettivo etico della ricerca è stato, invece, il miglioramento delle relazioni tra i fornitori "forti" e subfornitori "deboli" (classicamente PMI Piccole e Medie Imprese) essendo ancora oggi troppo spesso questi ultimi costretti a dover fare le spese delle inefficienze che i prime-contractors generano nei sistemi integrati di produzione ma anche, per contro, quello di garantire ai main-contractors, il rispetto degli impegni assunti, molte volte con leggerezza, dai sub-contractors (con conseguente messa a repentaglio sia del risultato economico sia della credibilità del prime-contractor stesso).

In effetti ormai da alcuni anni ha iniziato a farsi strada l'idea di condivisione, da parte di più utenti posti in siti geograficamente diversi, di stessi complessi modelli algoritmici in generale e di simulazione in particolare; questo fenomeno è fortemente collegato anche al progressivo prendere piede di reti telematiche via via più accessibili e capillarmente diffuse, nonché alla contrazione dei costi e dei tempi del processo gestionale e decisionale ottenibili in questo modo.

Le prime applicazioni sono oramai state estesamente collaudate in settori applicativi specifici e si sta osservando una tendenza ad estendersi delle stesse a nuove aree tematiche ed a riguardare via via anche il settore industriale tradizionale.

Il settore dell'impiantistica industriale, sotto questo punto di vista, è particolarmente sensibile dato che i progetti sono da sempre fortemente caratterizzati da esigenze di coordinamento tra vasti team di lavoro distribuiti geograficamente e fortemente integrati in diverse componenti disciplinari su attività complesse; tuttavia sono state valutate anche potenzialità legate al settore dei pubblici servizi identificando un buon potenziale in questo settore per l'analisi funzionale dei sistemi.

Gli sviluppi nei settori avanzati in cui queste tecniche sono oggi particolarmente diffuse (industria aerospaziale e militare) hanno portato alla definizione di standard operativi ed allo sviluppo di nuove tecnologie applicative; l'area è molto dinamica tuttavia l'evoluzione risulta ben coordinata e permette di garantire buona operatività agli strumenti che sono in corso di sviluppo; in particolare gli standard DIS (Distributed Interactive Simulation), HLA (High Level Architecture) uniti al diffondersi e stabilizzarsi di linguaggi ed ambienti dedicati JAVA, VRML 2.0, Corba rendono possibile procedere attivamente nello sviluppo di queste applicazioni. Già dal 1996 presso il DIP dell'Università di Genova si sono sviluppate applicazioni in questo settore tematico sulla base delle esperienze maturate precedentemente nel settore della simulazione e sull'importanza di integrare questi modelli con gli utenti finali: in particolare per quanto riguarda applicazioni al settore dei progetti d'impianto (progetto VAED: Virtual Aided Engineering and Desing), al settore della Logistica distribuita (Progetto Poseidon: Port Simulation Environment for Interactive Distributed Organization & Networking), al settore dell'Analisi di Rischio e di Sicurezza (Progetti Safety First: Settore Marittimo, CIPROS: Impianti Industriali e Protezione Civile) ed altri settori che richiedono l'interattività distribuita (traffici marittimi, formazione). Alcuni demo di questi progetti sono disponibili sulla rete WEB.

Tali sistemi sono attualmente in fase di integrazione con strutture che riproducono la gestione della commessa e le varie fasi di project management e che operano direttamente sulla rete; dimostratori tecnologici di questi sistemi sono già stati sperimentati a scopo formativo sia in ambito universitario che aziendale fornendo ottimi risultati.

Come già accennato queste collaborazioni si sono svolte su base internazionale ed in particolare hanno portato a contatti e collaborazioni con altri gruppi di riferimento nel settore in Europa ed in Nord America; sono stati effettuati scambi di studenti in particolare con la Otto-von-Guericke-University di Magdeburgo (Germania), la Riga Technical University, la Bogazici University (Istanbul Turchia) ed il National Center for Simulation e lInstitute for Training and Simulation di Orlando (Florida); in effetti già da tempo il DIP di Genova è un riferimento internazionale nel settore della simulazione, nel quale è attivamente coinvolto nei principali eventi (Simulation in Industry Conference 1996); la seconda edizione (San Francisco 1999) della conferenza Web-Based Modelling & Simulation che si tiene annualmente negli Stati Uniti su queste tematiche è stata coordinata da un membro del DIP quale General Chairman. Le tecnologie esistenti spingono ad operare utilizzando principalmente sistemi basati sui linguaggi dedicati al Web-Based Modelling e quindi JAVA e VRML: per queste ragioni sono stati attivati progetti per sperimentare le potenzialità di questi strumenti nel settore relativo all'impiantistica ed alla produzione industriale.

All'inizio del 1998 il gruppo di ricerca sulla simulazione discreta e stocastica del DIP di Genova, nell'ambito di un progetto del Fondo Sociale Europeo avente come scopo la crescita gestionale di alcuni subfornitori dell'unità produttiva ligure di una azienda multinazionale, il cui "core business" è rappresentato dalla fabbricazione di elettromotrici per la trazione ferroviaria, ispirandosi in qualche misura all'idea esposta al precedente paragrafo, provvedeva a studiare prima e ad implementare poi un primo embrione di rete gerarchica di simulatori on line/real time per la gestione integrata della produzione di tre distinti sistemi produttivi interagenti a due livelli gerarchici.

I tre simulatori, uno per il main contractor e uno ciascuno per i due subfornitori, ad eventi discreti, stocastici e di grande dettaglio sono stati scritti utilizzando il linguaggio di simulazione object oriented MODSIM (CACI La Jolla - California). Ogni simulatore riceve informazioni sull'andamento della produzione direttamente dal Sistema Informativo (è possibile importare dati da diversi sistemi di ERP). Infatti il meccanismo di connessione al database permette a chi sviluppa in MODSIM di effettuare operazioni su tutti quei database per i quali è previsto un driver di tipo Open Database Connectivity (ODBC). Inoltre è possibile caricare grossi volumi di dati nel database usando direttamente istruzioni SQL nel codice MODSIM. I simulatori possono essere connessi in modo semplice attraverso uno specifico socket; la applicazioni potenziali di questa tecnologia includono sia la simulazione distribuita, dove nodi differenti sulla rete considerata sono processati utilizzando una scomposizione del modello in elementi concorrenti, sia un network di simulatori dove diversi modelli di simulazione possono interagire attraverso la rete. Questi, correttamente sincronizzati e programmati da un supervisore di sistema, calcolano le proiezioni di futuri andamenti di produzione. Allorquando, per una qualsivoglia ragione, l'andamento programmato della produzione del main contractor (con accelerazioni o decelerazioni) è differente dalla previsione, i dati di riprogrammazione, testati dal simulatore principale, con conseguente evidenziazione di eventuali criticità su date di consegna, quantità di materiali e/o di manodopera per servizi, etc., vengono trasmessi ai simulatori/schedulatori locali che provvedono ad elaborare i nuovi piani di produzione dei subfornitori (adeguando a loro volta i piani di acquisizione di materie prime, semilavorati, etc., dai subfornitori); piani che verranno, quindi, ritrasmessi al simulatore principale per ulteriori verifiche di compatibilità. Stante i tempi stretti imposti dalla ricerca il Gruppo DIP si rese subito conto della impossibilità di poter ripetere per tre volte l'operazione di costruzione di tre diversi simulatori, per cui preferì dare vita ad una shell multi purpose (denominata OSIRIS, Object Simulator Interconnected Reuseable Integrated System) che fosse, almeno entro certi limiti, facilmente adattabile alle tre realtà in studio. L'attuale fase di sperimentazione, di questa complessa architettura a rete di simulatori/schedulatori interagenti, sta fornendo risultati molto validi e prospetticamente interessanti, su un problema strategico quale quello della subfornitura.

La sperimentazione di queste tematiche sulle applicazioni registrate si è dimostrata potenzialmente molto importante ed i risultati ottenuti hanno consentito di completare la fase di analisi di fattibilità e l'identificazione di principi guida e regole per lo sviluppo di questo genere di applicazioni, con riferimento al settore della gestione di progetti distribuiti ed alla gestione di sistemi logistici; le prime applicazioni condotte hanno permesso di verificare reali la validità degli strumenti messi a punto ed i margini di miglioramento conseguibili.

Si e’ ritenuto quindi opportuno estendere questa ricerca per lo sviluppo di una base metodologica profonda per questo genere di applicazioni estendendo decisamente il loro uso nel settore industriale tramite un impegno comune di ricerca con altre sedi universitarie in un progetto come quello qui riproposto.

In questo progetto Genova ha provveduto anche alla messa a punto di modelli di schedulazione per la programmazione della produzione dei siti industriali costituenti la catena di subfornitura oggetto della ricerca, al fine di estendere la convalida degli studi in corso.

Per quanto riguarda l'opportunità di utilizzo di HLA la sede Genovese ha operato come responsabile della valutazione delle diverse architetture di supporto per la realizzazione delle reti di simulatori schedulatori, sviluppando moduli in JAVA e C++ nonché integrazioni per confrontare le performance di HLA con quelle di altre architetture con pacchetti di simulazione attivi quali Automod, Simul8, Arena.

Sviluppi di schedulatori intelligenti con particolari caratteristiche capaci di una visione d’insieme della rete logistica sono inoltre previsti come sviluppi in altri progetti (i.e. WILD Web Integrated Logistics Designer, che coinvolge praticamente tutti i partner del presente studio).

DEF, Firenze

Nell’ambito della presente ricerca è stata definita una metodologia generale per l’allocazione e lo scheduling delle risorse umane in sistemi manifatturieri di tipo labour-intensive. La metodologia è stata validata in un contesto reale, relativo alla produzione di macchinari per l’industria tessile. L’approccio seguito ha previsto la formalizzazione dei vari task di produzione con diagrammi di Gantt, la definizione dei tempi di completamento dei singoli task in rapporto ad un tempo standard di completamento (in corrispondenza dell’assegnazione di un numero standard di risorse), ed infine la definizione della competency matrix degli operatori, identificando così gruppi omogenei, ai fini dell’assegnazione degli addetti, dal punto di vista delle competenze possedute. Tramite un modello di simulazione dinamico, che a step regolari esegue il re-scheduling delle attività da eseguire nel reparto, è stato possibile indagare la bontà delle differenti logiche, adottate nel sistema per la gestione delle squadre di lavoratori.

La procedura ha potuto essere quindi generalizzata, fornendo le modalità di validazione dei modelli di simulazione/schedulazione e l’impostazione dell’architettura generale di analisi (basata su tecniche DOE). Sulla base delle esperienze maturate la metodologia si è dimostrata applicabile in numerosi contesti, ovvero in ogni sistema produttivo che preveda un forte apporto di manodopera qualificata, organizzata in squadre, per l’esecuzione di task numerosi, simultanei, e di significativa durata, ed in cui il problema gestionale sia principalmente legato alla ricerca della migliore logica di assegnazione degli operatori (rientrando in questa casistica tutte le produzioni pesanti che richiedono assiemaggio finale, ad esempio realizzazione di impianti, grandi attrezzature, macchinari, come pure il contesto della manutenzione di impianti effettuata da personale specializzato).

Logica di allocazione delle risorse, da cui deriva lo scheduling dei tasks.

DIMEG, Bari

In parallelo Bari ha costruito un modello di schedulazione delle attività di una produzione "per project" finalizzato alla determinazione delle date di inizio e fine delle attività del progetto nel rispetto dei vincoli:

Il modello è applicabile ad un set di N progetti

identici, corrispondenti alla realizzazione di altrettanti prodotti. Un

assegnato piano di produzione definisce la data di consegna di ciascun

prodotto, ![]() . Le attività

. Le attività ![]() del k-esimo progetto e i vincoli tecnologici fra di esse sono rappresentabili

mediante logica PERT. Si è indicato con Wk

il set degli eventi nel reticolo PERT relativo al k-esimo prodotto. Sono

stati introdotti vincoli fra attività di due prodotti realizzati

in successione a causa di un’eventuale disponibilità limitata di

alcune attrezzature. Le durate delle attività

del k-esimo progetto e i vincoli tecnologici fra di esse sono rappresentabili

mediante logica PERT. Si è indicato con Wk

il set degli eventi nel reticolo PERT relativo al k-esimo prodotto. Sono

stati introdotti vincoli fra attività di due prodotti realizzati

in successione a causa di un’eventuale disponibilità limitata di

alcune attrezzature. Le durate delle attività ![]() possono variare in un range

possono variare in un range ![]() in funzione delle risorse assegnate all’attività

in funzione delle risorse assegnate all’attività ![]() .

Maggiori sono le risorse allocate ad un’attività, minore è

il tempo richiesto per la sua esecuzione. Ad un maggiore impiego di risorse

corrisponde anche un aumento del costo diretto dell’attività

.

Maggiori sono le risorse allocate ad un’attività, minore è

il tempo richiesto per la sua esecuzione. Ad un maggiore impiego di risorse

corrisponde anche un aumento del costo diretto dell’attività ![]() .

.

Si è assunta una dipendenza lineare fra costo diretto e durata per la singola operazione:

![]()

![]() ,

, ![]()

dove:

![]() : intercetta

con l’asse del costo diretto;

: intercetta

con l’asse del costo diretto;

![]() : aumento

del costo diretto per l’attività

: aumento

del costo diretto per l’attività ![]() per unità di riduzione della durata

per unità di riduzione della durata![]()

Si è impostato il problema di schedulazione come problema di programmazione lineare finalizzato alla minimizzazione del costo diretto complessivo del progetto:

sottoposto ai seguenti vincoli:

![]() V.1

V.1

![]() V.2

V.2

![]() V.3

V.3

![]() V.4

V.4

dove:

![]() : istante dell’i-esimo

evento del k-esimo prodotto;

: istante dell’i-esimo

evento del k-esimo prodotto;

![]() : set delle

attività del k-esimo prodotto che precedono attività del

(k+1)-esimo prodotto;

: set delle

attività del k-esimo prodotto che precedono attività del

(k+1)-esimo prodotto;

![]() : evento

finale del reticolo PERT di ciascun prodotto.

: evento

finale del reticolo PERT di ciascun prodotto.

I vincoli V.1 definiscono l’intervallo di tempo impegnabile per ciascuna attività. I vincoli V.2 rappresentano le precedenze fra attività diverse del medesimo prodotto. I vincoli V.3 introducono precedenze fra sottogruppi di attività di due prodotti realizzati in sequenza. Infine, i vincoli V.4 impongono che la data di completamento di ciascun prodotto sia coerente con la data di consegna assegnata.

Lo schedulatore è stato implementato mediante un solver di programmazione matematica "What’s best" - LINDO®(rel. 5.0). Tale package commerciale è in grado di risolvere problemi anche di notevole complessità computazionale; esso consente infatti di gestire un numero illimitato di variabili e di equazioni di vincolo. Si tratta di un software di facile impiego e di immediata integrazione in ambiente "Visual Basic Application" (VBA) con altri package commerciali in quanto utilizza l’interfaccia di "Excel" sia per la formulazione del problema sia per la presentazione dei risultati.

DE, L’Aquila

Il programma di ricerca presso il team di ricerca dell’Aquila è stato teso allo sviluppo ed integrazione di simulatori e schedulatori per lo studio di sistemi manifatturieri complessi composti da più soggetti interagenti. La prima attività intrapresa è stata dunque la messa a punto di un sistema di schedulazione flessibile che fungesse da strumento operativo per le successive fasi della ricerca. Lo sviluppo di tale sistema di schedulazione è avvenuto basandosi su un caso di studio reale in cui le problematiche di scheduling si presentano particolarmente impegnative. Il sistema sviluppato è comunque flessibile e facilmente riconfigurabile per essere adattato ad una ampia gamma di casi manifatturieri. L’azienda scelta per lo sviluppo iniziale del sistema di schedulazione è la Italpneumatica Sud di Carsoli (AQ), struttura produttiva della SMC Italia, che produce cilindri pneumatici per il mercato italiano ed europeo. Lo stabilimento, che occupa una superficie coperta di circa 10.000 m2 con oltre 100 addetti, è organizzato in due reparti (lavorazione componenti, assemblaggio) e tre magazzini (materie prime, componenti, prodotti finiti). Lo scenario produttivo è caratterizzato da circa 1000 ordini in process per un totale di circa 4000 operazioni da schedulare su 46 macchine utensili CNC e 11 isole di assemblaggio; gli ordini di produzione provengono, all’incirca in ugual misura, dal controllo delle scorte (prodotti e componenti standard) e dai clienti (prodotti non standard e speciali); le due tipologie di ordini sono caratterizzate da lead time molto diversi (1-2 mesi contro 1-2 settimane). Da circa due anni l’azienda sta sperimentando in produzione il prototipo di un sistema integrato di scheduling e di controllo avanzamento produzione appositamente sviluppato nell’ambito di un altro progetto di ricerca applicata. Tale sistema rende disponibili un notevole quantitativo di dati sugli ordini lanciati, sui cicli di produzione, sui tempi di lavorazione e di setup, sulla disponibilità delle risorse che sono stati utilizzati per la convalida e la verifica delle prestazioni dello schedulatore.

Lo schedulatore sviluppato risulta essere di tipo euristico ed è caratterizzato dalla capacità di operare a più livelli di aggregazione dei job, cioè in grado di scegliere prima una famiglia, da questa una sottofamiglia, e infine il job. Appartengono alla stessa famiglia (o sottofamiglia) i job che richiedono lo stesso setup. Nelle successive scelte risale al livello superiore solo quando i job o le sottofamiglie del livello attuale sono esauriti. Ovviamente le regole utilizzate per scegliere un sottoinsieme di job considerano le caratteristiche di tutti i job dei diversi sottoinsiemi in competizione: ad esempio la data di consegna può essere sostituita con una variabile del tipo numero di job del sottoinsieme con data di consegna compresa in un determinato intervallo. Di fatto sono state sperimentate regole basate sulla ottimizzazione di una funzione obiettivo rappresentata da un polinomio i cui termini sono costituiti dal valore di una variabile calcolata su diverse caratteristiche dei sottoinsiemi (numero di job, tempo totale di lavorazione, tempo di setup per la famiglia, numero di job con data di consegna critica, ecc.). Una prima versione dello schedulatore è stata utilizzata per oltre un anno nella programmazione operativa della produzione della Italpneumatica. Nel corso della ricerca è stata sviluppata una seconda versione che, mantenendo le principali caratteristiche della precedente, rispondesse ai seguenti requisiti:

DIG, Milano

L’unità di Milano si è dedicata in passato alla creazione di modelli di simulazione per il mondo manifatturiero ed industriale in genere sia per la gestione e schedulazione della produzione che per la progettazione di impianti produttivi, per realtà industriali interessate all’impiego dello strumento della simulazione. I programmi normalmente impiegati partono dalla programmazione ad oggetti applicata al mondo della simulazione (SIMPLE++), ad ambienti più user friendly (Simul8, Arena, Witness).

Tramite un modello di simulazione è possibile prevedere il comportamento di un sistema nelle condizioni che prevedibilmente si presenteranno nel corso del suo normale utilizzo e funzionamento pratico. La natura assolutamente generale della simulazione ne permette un utilizzo in diversi settori merceologici e di servizio. In particolare, il suo utilizzo nelle realtà produttive e dei servizi si rivela particolarmente utile per:

Shell di Simulazione User Friendly per Ampia Gamma di Casi Manufatturieri

DIP Genova

Lo studio originario si e’ sviluppato a partire dalla necessita’ di integrare ricerche presistenti relativi alla gestione della supply chain tramite una shell sviluppata dal team Genovese per un case study di produzione locomotori (Bombardier ex ADTranz).

Detto studio e’ stato la causa prima del corrente progetto per cui gli sviluppi degli strumenti originariamente costruiti e l’analisi delle esperienze raccolte e’ risultato essere il cuore ed il motore di tutte le attivit’ seguenti.

Lo strumento chiave realizzato in origine, e denominato OSIRIS, forniva tutta una serie di facilities per lo studio della produzione e della logistica di impianti in modo rapido ed efficace

Architettura funzionale OSIRIS

La shell OSIRIS sviluppata nel 1998 per affrontare una serie di problemi di logistica e manufacturing e’ uno strumento di simulazione, che predilige il caso di impianti monoprodotto, anche se puo’ essere adattato a configurazioni multiprodotto. Nel caso del dimostratore relativo all’aeronautica esistono due realtà: una monoprodotto Genova ed una pluriprodotto Finale. Detto questo, l’intenzione iniziale era quella di adottare OSIRIS per Genova e non Finale, (a Finale si rileva la necessità di uno strumento di simulazione che sia in grado di simulare il processo produttivo di almeno 300 pezzi). Per quanto riguarda lo schedulatore (realizzato in Visual Basic 6.0 ed in grado di collegarsi ad un database esterno via ODBC con oggetti DAO), questo è stato completato e testato in riferimento ad industrie di carpenteria meccanica (i.e.PSTL OMG) ed è stato studiato per funzionare su circa 1000 articoli; la tecnica di schedulazione utilizzata è stata derivata direttamente dalle euristiche di tipo EDD e CR (con alcune modifiche per una maggiore adattabilità al caso). Questa tecnica, prevede un’allocazione delle fasi di lavorazione sulle diverse macchine, presenti nel sito produttivo, ed una continua scansione sia delle risorse (ricerca di risorse nello stato di idle/busy) sia delle code a monte di ogni macchina. Queste ultime sono riordinate per ogni evento temporale significativo ai fini dell’avanzamento della produzione. Eventi significativi possono essere il rilascio di una risorsa, l’arrivo di materiale, il guasto di una macchina utensile, ecc…, riprendendo una sorta di schedulazione scan e rescan. Il sistema risulta efficace ancorche’ vi siano margini di ottimizzazione dal punto di vista prestazionale. La schedulazione, così effettuata, è di tipo forward e per questo in grado di guardare solo avanti nel tempo e realizza un piano di produzione teso alla saturazione delle risorse produttive od in altre parole al produrre al più presto possibile. Questo tipo di schedulazione earliness, che per sua implicita natura tende a creare elevati valori di WIP (work in progress), è stata preferita a tecniche di tipo tardiness, più eleganti ed ottimizzate, ma meno "sicure" per quanto concerne un aspetto di previsione e controllo delle consegne puntuale come nel presente progetto. Poiché la schedulazione realizzata durante l’allocazione delle risorse non è in grado di considerare la stocasticità del processo, l’architettura è completata, come classico, da uno schedulatore che, prendendo come input l’MPS verifica in regime stocastico il piano. Questa funzione può essere assunta da OSIRIS (al quale sono state aggiunte le opportune microistruzioni per la generazione dei messaggi da inviare sul socket per RTI). Riferendoci a quest’ultimo aspetto si e’ aggiunta una macro istruzione GenMessage che se opportunamente "agganciata" ad un programma Java può inviare messaggi di testo di qualunque tipo ed un’altra di triggering (chiamata Filter) che blocca l’esecuzione di un processo simulato in attesa di un messaggio dall’esterno. OSIRIS è realizzato con MODSIM III, le modifiche al pacchetto non sono risultate banali ed hanno richiesto circa 1 mese uomo di lavoro e sono state completate nella prima meta’ del progetto. Lo schedulatore è stato realizzato in Visual Basic ha evidenziato la necessità di migliorare la gestione dei calendari di ogni macchina e dei routings alternativi, fornisce una robusta interfaccia grafica, facile ed intuitiva che permette la generazione, memorizzazione e gestione di differenti scenari in automatico, genera un MPS in formato testo separato da tabulatori completo, ed ha una sezione di analisi dei dati con grafici per ogni macchina, prodotto, cliente e per le loro interazioni, fornisce dati di sintesi relativi a ritardi, anticipi, carichi macchina in un intervallo temporale, cumulative di produzione, etc.

DIMEG, Bari

In parallelo a queste iniziative ed al fine di pervenire ad una descrizione realistica del comportamento del sistema produttivo, la sede di Bari ha costruito un simulatore che consideri, oltre alla sequenza e alla durata delle attività del processo produttivo, la presenza di fenomeni locali, quali:

Il simulatore sviluppato dall’unità di ricerca del Politecnico di Bari è stato implementato in ARENA®. La scelta del software di simulazione è stata determinata da diversi fattori fra cui:

Il software è interfacciabile in ambiente VBA. Tale caratteristica ne consente la facile integrazione con moduli realizzati con altri software al fine di ottimizzare lo scheduling della produzione e, più in generale, la gestione delle risorse.

DEF, Firenze

Le applicazioni di SM&A (Simulation Modelling & Analysis) richiedono l’esecuzione di una serie di fasi di modeling e di analisi che sono estremamente critiche ai fini del successo dell’applicazione. Per questo scopo, è stata sviluppata una procedura di validazione e di analisi, valida per un ampia gamma di casi manifatturieri, che si basa sulla architettura rappresentata in figura.

Framework per SM&A

La procedura di validazione utilizza una t-statistic,

opportunamente sviluppata, per dare evidenza della bontà dei dati

in uscita dal simulatore, mentre il framework di analisi dei risultati

del simulatore utilizza esperimenti fattoriali ed esperimenti di tipo composto

centrale. L’architettura proposta può essere implementata utilizzando

come kernel di simulazione un qualunque ambiente che sia programmabile

dall’interno o controllabile dall’esterno (praticamente tutti i principali

simulatori commercializzati). L’interfaccia utente può essere resa

quanto di più semplice da utilizzare si possa ipotizzare, e l’architettura

può essere orientata all’utilizzo in tempo reale del simulatore,

nella validazione di schedule e di soluzioni alternative nella programmazione

operativa della produzione.

DE, L’Aquila

La sede di L’Aquila ha preferito orientarsi verso l’utilizzo di un ambiente di simulazione per sistemi manifatturieri ad eventi discreti general purpose di tipo commerciale anziché sviluppare uno shell di simulazione ad hoc. L’ambiente di simulazione prescelto è ARENA della System Modeling Corp., sviluppato sulla base del linguaggio dedicato SIMAN. A tale scopo è stata acquisita la Release 4 del pacchetto software in versione multilicenza al fine di permettere la simulazione contemporanea su più computer in rete.

Motivazioni della scelta sono state le seguenti:

DIMEC, Salerno

Il software di simulazione scelto, per la realizzazione del modello, è "ARENA Professional Edition" della System Modelling Corporation. Tale pacchetto si caratterizza per la estrema semplicità di sviluppo di modelli di simulazioni che hanno per oggetto realtà industriali.

Arena è un pacchetto software che consente di costruire modelli costituiti da moduli; la collocazione di un modulo all’interno della shell grafica equivale alla scrittura di un blocco funzionale in linguaggio SIMAN.

Gli elementi caratteristici dell’ambiente di simulazione, che consentono il corretto funzionamento del modello progettato, sono essenzialmente due: i moduli e le entità.

Il software, grazie ad una shell di progettazione molto semplice ed intuitiva, consente di costruire, mediante moduli opportuni, che possono essere di alto o di basso livello, tutte le fasi logiche e di processo dell’azienda che si intende modellare e di collegarle secondo la logica desiderata.

I moduli consentono tra l’altro di realizzare sia delle fasi produttive quali stazioni di processo, code, magazzini, stazioni di ispezione, carico/scarico da carrelli, risorse, trasporti, ecc., sia delle fasi logiche quali decisioni, assegnazioni di attributi, esecuzione di porzioni di codice Visual Basic, ecc.

Le entità sono degli oggetti che movendosi all’interno del modello tra i vari moduli rendono possibile la simulazione; esse possono rappresentare dei semplici flussi logici oppure dei prodotti che evolvono all’interno del sistema.

I moduli posizionati nella shell svolgono le operazioni preposte soltanto quando le entità li attraversano; ciò rende possibile sviluppare ed in seguito verificare il funzionamento del modello in modo molto semplice; infatti, quando il modello viene eseguito, la shell di progettazione diviene una finestra di visualizzazione che consente di vedere graficamente il passaggio delle diverse entità all’interno del sistema, nonché di verificare le operazione svolte dai moduli.

Al termine della simulazione l’ambiente offre la possibilità di visualizzare un report che contiene tutte le informazioni relative alla simulazione appena svolta.

DPGI, Napoli

Per la realizzazione del modello di simulazione, si è dovuta operare una scelta tra le diverse possibilità offerte dal mercato in termini di software di simulazione. Tale scelta ha privilegiato il software di simulazione "ARENA Professional Edition" della System Modelling Corporation. Il pacchetto si caratterizza per la estrema semplicità di sviluppo di modelli di simulazioni che hanno per oggetto realtà industriali.

Non ultima tra le motivazioni che hanno condotto a tale

scelta è la competenza già posseduta dai componenti dell’unità

operativa di Napoli nello sviluppo di modelli di simulazione con tale applicativo.

Stato dell’Arte e Sistemi Preesistenti

DIP, Genova

Essendo OSIRIS ovviamente uno sviluppo originariamente legato ad una applicazione particolare, ancorche’ sufficientemente complessa da risultare rappresentativa, si sono evidenziati nel suo impiego una serie di limiti di generalizzazione che il presente progetto si e’ prefisso di correggere ed integrare.

La sede di Genova ha quindi inizialmente lavorato sull'evoluzione della shell di simulazione OSIRIS definendo i formati file idonei all'interfacciamento con sistemi ERP (Enterprise Resource Planning) e realizzando nuove istruzioni che consentono l'accesso dinamico a Database SQL; la shell attualmente risulta operativa anche in ambiente Windows NT, mentre l'implementazione Unix e l'interfaccia Java sono state sospese a favore di altri tools dedicati piu' efficaci visto anche che il motore di base (Modsim III), dopo l’acquisto di CACI da parte di Compuware, ha un futuro incerto e potrebbe risultare non più economicamente manutenibile; la costruzione dei nuovi tools si è basata sia sull'impiego di Automod/Autosched, tools sul cui impiego esiste una collaborazione tra DIP e Ford Motor Company (Detroit – U.S.A., Dott. Edward Williams), che sullo sviluppo di tools ad hoc in Java e C++.

Passaggio di OSIRIS su Unix e NT

Il software utilizzato per lo sviluppo dell’applicativo

OSIRIS, MODSIM III di Caci Products Company, aveva tra le sue caratteristiche

di rilievo, la possibilità di operare senza modifiche al codice

sia in ambiente Microsoft Windows che in ambiente UNIX. Questo è

stato possibile fino alla versione 1.3.2 del prodotto stesso (versione

attuale 2.3.0), versione oggi non più supportata a causa del passaggio

di proprietà del prodotto stesso alla società CompuWare.

Quest’ultima avendo abbandonato, per i prodotti di simulazione la piattaforma

Unix, non ha ritenuto fosse di rilievo strategico la migrazione e l’aggiornamento

del linguaggio di simulazione in ambiente Unix, decidendo per la sospensione

delle chiavi di attivazione delle vecchie licenze (queste andavano ripristinate

una volta all’anno). CompuWare inoltre ha deciso per la totale sospensione

del pacchetto a partire dall’anno 2001, fornendo però in questo

caso una licenza permanente d’uso per la piattaforma Microsoft (con software

identico per il S.O. NT e 98). La CompuWare rimane ad oggi disponibile

a fornire tools di simulazione, purtroppo non più compatibili

con il codice MODSIM generato, che ritiene maggiormente innovativi e funzionali.

I test ad oggi prodotti sulla piattaforma NT hanno dimostrato un’ottima

funzionalità sia in termini di affidabilità del codice prodotto

che dell’efficienza dello stesso. Il linguaggio di simulazione è

stato utilizzato per circa dieci applicazioni differenti (modelli di microtraffico,

configuratori di impianto, shell di schedulazione, sistemi integrati) dimostrando

solo qualche carenza nell’ambito dell’interfaccia grafica povera sia in

termini di estetica che di funzionalità ed implementazione, costringendo

molte volte alla generazione della stessa attraverso altri tools

di sviluppo quali ad esempio Microsoft Visual Basic (I2 techologies con

il prodotto Supply Chain Strategist) ed un motore di schedulazione in MODSIM

III. Buoni i test sulla gestione dell’I/O, efficacemente supportato dal

driver

ODBC. Sufficiente il giudizio sulla gestione dinamica della memoria non

sempre in grado di deallocare processi di cui si è autorizzato da

programma il dispose vincolando in questo modo lunghe simulazioni.

Insufficiente per quanto riguarda il supporto del protocollo HLA supportato

in un primo momento ed successivamente ritirato (specifiche non conformi)

a partire dalla versione 1.3.5, mai più ripristinato. Altrettanto

non può essere detto per l’ambiente Microsoft Windows 98 che presenta

alcune lacune di compatibilità in funzione del sistema utilizzato

(italiano od inglese ad esempio), lacune riscontrate a livello delle librerie

dinamiche di gestione della visualizzazione delle interfacce difficilmente

risolubili e non documentate (se ne sconsiglia quindi l’uso in ambiente

98). Valgono gli stessi risultati degli altri tests in ambito NT

qualora il programma non presenti interfaccia grafica.

Nuove Microistruzioni Sviluppate per OSIRIS

Le microistruzioni attualmente implementate sulla versione

di OSIRIS (Object Interconnected Reusable Integrated System release 2.1)

sono 15 e possono essere riassunte come segue:

| Assembly | This assembly operation transforms

different items in work in process or finished goods.

Fields: Work in process name or item name needs to be assembled (Identifier); Needing mechanical resource name to make possible assembly operation (Resource to assembly); Assembly operation learning curve can be associated to current work in process or product (Learning curve button). In combo box list are presented all learning curve defined in Operation list in Operation Learning Curve window; |

|

| Delay | This elementary operation means

simulation time elapsing (each working operation can be modeled through

time parameter definition).

Fields: Identifier; Operation time (Waiting Time), statistics distributions can be chosen, and expressed in hours unit time; |

|

| End | Involves process execution end;

Process

end detail dialog box appears equal to Message detail

dialog

box. End operation isn’t a real elementary operation but a process-end

message.

Requested data are: Message identifier; Message type; Item’s name; it will be used to refer items in system buffer; Message sender object; Message receiver object; Time to wait before sending message; Quality (not used); Quantity (not used); Broadcast message check box. End operation is set to terminate each process. It is important to underline End operation performs message sending such as DEP.ini, PUSH OBJECT or PROCESS COMPLETED, if trace file is required; |

|

| Filter | Filter operation allows process

interrupt until some event occurs (a message for instance).

Identifier; Message list in which user defines messages have to be received to start again process; |

|

| GenMessage | This operation is able to generate

external message with a specific text message.

Fields: Identifier; Kind of Action combo box allows actions selecting to execute when message arrives; New Action button features new action creation; Edit Action button features message setting modifying; Message button features message type definition to wait for activation; |

|

| Get | This operation involves item or

product request.

Fields: Identifier; Requested object name; |

|

| GetHum | This operation involves human

resource request.

Fields: Identifier; Resource List button allows to access human resource list previously defined in Human Resource creation process. Get human operation requires only once resource. When resource isn’t available model manager puts unsatisfied request in FIFO queue until some resource will become free. Fields: Identifier; Human resource name; Resource number to acquire; |

|

| GetMech | Mechanical resource operation. Dialog box and fields in this elementary operation are equal to GetHum operation settings; | |

| Message | Through this operation it is possible sending messages to active objects. Messages are used to synchronize activities between objects. Message button actives message definition window; | |

| MoveTo | Simulates work in

process transportation across layout (for instance from a work-centre to

other).

Fields: Identifier; Travel Time, expressed in hour unit time. Combo box allows to choice proper statistics distribution; Destination gate; |

|

| Release | Release resource operation previously acquired and used for process. It becomes immediately available to satisfy further requests. Dialog box use is equal to GetHum and GetMech operations; | |

| Test | Test operation allows

process final testing to verify item or product quality.

Like assembly operation, test operation is usually associated to progress or learning curve. Fields: Identifier, for instance TEST_INVERTER; Necessary resource to execute test operation (Resource to test), for instance TEAM_TEST; Learning curve related to a particular product type. Combo box shows all implemented curves. They are defined in Operation list menu by filling in Operation Learning Curve. |

|

Aggancio Moduli ODBC/SQL OSIRIS

Attualmente sono state sviluppate due differenti modalità di collegamento ad un database compatibile con il driver ODBC. Il test più esaustivo è stato eseguito sul database di tipo SQL (Microsoft SQL 7.0), ma lo stesso programma ha fornito risultati soddisfacenti anche con database di tipo DBF. Esiste inoltre la possibilità di sfruttare le funzionalità, via ODBC, ad un database di tipo ORACLE™.

Interfaccia Microsoft Excel OSIRIS

Lo sviluppo in ambiente Microsoft Excel™ può essere riadattato modificando i soli trace records che sono definiti all’interno del database aziendale; il collegamento avviene attraverso drivers ODBC con oggetti OLE ed infine comandi ActiveX Microsoft.

Il sistema, inoltre, dispone dei comandi e delle procedure necessari all’interazione con lo schedulatore descritto ai punti precedenti, è cioè in grado di generare i files nel formato richiesto dallo schedulatore. Il front-end realizzato fornisce allo schedulatore ed ad un eventuale modello di simulazione tutti i dati necessari per operare un’attività di pianificazione e programmazione della produzione; utilizzando le maschere presenti, è possibile variare tutti i parametri del processo produttivo (quali operatori, macchine utensili, tempi, etc.), modifica che consente di valutare i risultati ottenibili attraverso eventuali nuove definizioni dei criteri gestionali dell’intero ciclo produttivo (generazione degli scenari). Con operazioni estremamente semplici e rapide, si possono modificare i parametri sulla base dei quali effettuare l’analisi, allo scopo di verificare le possibili variazioni della risposta ottenuta in uscita dal schedulatore.

Infine il sistema dispone di comandi necessari all’attivazione delle procedure di salvataggio dei dati, contenuti nel database di origine, nel corrispondente formato ASCII standard.

Interfaccia Visual Basic OSIRIS

Qualora la definizione degli input da fornire allo schedulatore richieda la riformattazione dei dati, confrontando i parametri richiesti dallo stesso rispetto a quanto presente direttamente nel database del sistema informativo aziendale (S.I.A.), è possibile sviluppare un modulo per l’importazione, il filtraggio e la manipolazione dei dati e la loro conversione nel formato richiesto dallo schedulatore.

Per facilitare l'utilizzo di tale operazione è opportuno utilizzare un front-end di facile consultazione ed allineato con il database originale; è stato quindi realizzato un modulo tramite l’utilizzo del linguaggio di programmazione Microsoft Visual Basic 6 (Enterprise Edition). La scelta è stata dettata dai seguenti requisiti fondamentali:

Il linguaggio di programmazione Visual Basic, è uno degli strumenti migliori per creare facilmente e rapidamente applicazioni in ambiente Windows, in quanto fornisce una serie di oggetti che permettono di semplificare la fase di sviluppo del programma. La parte Visual si riferisce al metodo utilizzato per creare l’interfaccia utente di tipo grafico (la cosiddetta GUI: Graphical User Interface). Infatti senza dover scrivere necessariamente codice è possibile creare facilmente l’interfaccia dell’applicazione che si sta implementando, utilizzando una serie di moduli base forniti dal programma.

La parte Basic fa riferimento al linguaggio BASIC (Beginners All-Purpose Symbolic Instruction Code), di cui risulta evidente la facilità con cui questo modulo può essere modificato, anche da personale non esperto, in vista di successive modifiche.

Visual Basic, come tutti i più moderni linguaggi di programmazione, supporta una serie di costrutti di utilizzo comune oltre che una serie di caratteristiche specifiche dovute alla sua peculiarità di essere un linguaggio di programmazione orientato agli oggetti e guidato agli eventi.

Inizialmente occorre definire le caratteristiche visualidell’applicazione che sono rappresentate sullo schermo attraverso l’utilizzo delle cosiddette "form", ad ognuno di esse è associato un modulo di codice (form module con estensione .frm) che contiene le procedure ad eventi relative a quel "form" ed a tutti gli oggetti che comprende; queste sono procedure che eseguono un comando in risposta ad uno specifico evento che si è verificato in precedenza o che è stato determinato dall’esterno. In aggiunta alle procedure ad eventi il "form module" può contenere delle procedure generali, indipendenti da qualsiasi "form", che sono definite in un altro modulo standard (standard module con estensione .bas). Per quanto riguarda la parte visuale è possibile utilizzare una serie di controlli standard che sono tipici delle applicazioni Windows quali ad esempio pulsanti, etichette, caselle di testo, pulsanti di opzione o menù a tendina, risulta inoltre essere possibile creare controlli personalizzati oppure recuperare controlli tipici di altri applicativi, quali ad esempi i fogli di lavoro di ExcelTM o le tabelle di AccessTM.

Nella fase di realizzazione del modulo d'importazione e gestione dei dati dall'archivio informatico di un’azienda si è utilizzata una libreria di oggetti di Visual Basic 6 dedicata alla gestione dei database: la libreria DAO. Il modulo DAO è costituito da un insieme di oggetti che determinano la struttura di un sistema di database relazionale; con le proprietà ed i metodi dagli oggetti DAO è possibile eseguire tutte le operazioni necessarie per gestire tale sistema, tra cui la creazione di database, la definizione di tabelle, campi ed indici, la relazione fra tabelle e l'esecuzione di queries nel database stesso. Le librerie DAO sono state le prime a disporre dei tools necessari ad effettuare sia la gestione di database Microsoft Jet, ovvero il modulo utilizzato da Microsoft AccessTM, ed a consentire la connessione diretta a tabelle di AccessTM e ad altri tipi di database tramite ODBC.

Nel modulo DAO sono disponibili quindici oggetti, tra cui ricordiamo i principali:

Spesso per alcuni gruppi è possibile procedere alla semplice estrazione dalle tabelle del S.I.A. utilizzando direttamente il linguaggio SQL nelle procedure di Visual Basic e quindi sfruttando la potenzialità degli oggetti DAO di connessione diretta al database Access.

Il front-end è molto semplice ed interattivo e, grazie ad una serie di pulsanti di comando e di menù a tendina, permette di accedere agevolmente agli altri pannelli del programma; ogni comando riporta l’indicazione del modulo a cui si sta accedendo completata da un’icona che richiama la funzione del modulo in questione. Il pannello principale permette, grazie a menù a tendina, di visualizzare direttamente il pannello modifica di ogni singola tabella del database locale per attuare le variazioni da apportare allo stesso prima della conversione dei file nel formato desiderato. I moduli che completano l’interfaccia sono sostanzialmente tre:

Il modulo di modifica del database, avviene su di una copia locale; questo presenta una serie di pulsanti di comando che riepilogano tutte le categorie di tabelle; una volta selezionata la tabella desiderata si accede ad un modulo dedicato che può essere utilizzato in due modalità distinte: con i tasti di modifica disabilitati od abilitati. Nel primo caso, è possibile utilizzare la barra di scorrimento associata alla tabella per evidenziare ogni singolo record con tutti i campi principali: in questa modalità non è possibile apportare modifiche a nessun dato contenuto nel database fino a quando tramite la selezione di un option button non si sono attivati tutti i tasti di modifica ed i text box relativi ad i record della tabella. Trovandosi, quindi, nella modalità di modifica dei record vi è la possibilità di compiere tre specifiche azioni sulla tabella:

Interfaccia collegamento ORACLE (via ODBC) OSIRIS

Nelle available references di Microsoft Visual Basic non si hanno di default le librerie di ORACLE quali ad esempio ORACLE InProc Server 3.0 Type Library. Al fine di creare una connessione ORACLE dobbiamo creare una DSN dedicata. E’ possibile utilizzare un controllo Oracle precedentemente scaricato dagli Ado Data Control components. Visualizzando le proprietà del comando ADO è possibile collegare lo stesso al DSN seguendo questa procedura:

selezionare dal Data Link Properties: 1) Microsoft OLE DB Provider For ODBC DRIVER, 2) Collegare la stringa: Build, 3) Connection + collegamento stringa + build + Machine data source + selezionare la DSN. Per creare una DSN: START + Settino + Control Panel + Data Source ODBC + System DSN + Add + Microsoft ODBC for ORACLE. E’ necessario quindi impostare il Data Source Name, l’User Name, la Password ed infine il Server (il SID del Server). A questo punto è necessario collegare il controllo Datagrid al controllo ADO ed rendere visibile l’output del codice SQL direttamente memorizzato su DataSource.

A questo seguono operazioni di installazione delle librerie dinamiche richieste (Nsusr32.dll in C:\winnt\System32) e la dichiarazione di tutte le variabili.

Link Java OSIRIS

Non essendo ancora disponibile, al momento del primo sviluppo prototipale della configurazione schedulatore/simulatore OSIRIS (1998), un protocollo di trasferimento delle informazioni che permettesse di collegare insieme differenti unità operative (con il termine unità operative si intende il software e la sua implementazione su di una base dati per ogni realtà di sub – fornitura ed una di controllo e supervisione per il main – contractor), un primo pensiero era andato alla realizzazione di un’interfaccia di trasferimento dei dati di output, e delle relative sincronizzazioni, attraverso la rete internet. E’ allora immediato capire il perché questa soluzione abbia preso, per lo meno in considerazione, l’utilizzo di un link realizzato con tecnologia Java. La scarsa affidabilità della rete internet ed il continuo susseguirsi di nuovi rilasci di versioni del linguaggio hanno, almeno in quella prima fase, spinto lo studio verso una soluzione che fosse semplice ed affidabile. Questo compromesso tra prestazioni e risultato è stato ottenuto facendo dialogare in modalità off-line le differenti unità operative, utilizzando la rete internet ed il protocollo FTP. Ogni unità operativa era dunque in grado di elaborare le proprie proiezioni, sia in regime deterministico sia in regime stocastico, inviandole ai livelli superiori. E’ evidente come questa soluzione sia carente dal punto di vista della sincronizzazione del tempo (richiesta di elaborazione da parte dei livelli superiori al fine di effettuare una previsione dei piani di produzione in tempo utile) limite, al tempo, valicato attraverso richieste in formato elettronico dei risultati intermedi necessari all’attività di pianificazione. Evidente appare quindi l’interesse suscitato da una tecnologia come HLA che permette, non solo di sincronizzare opportunamente le richieste di una attività di pianificazione a ritroso, a priori difficilmente identificabile ma anche di, ma anche di svincolarsi dal problema di unità operative non interconnesse tra di loro se non nei termini dei loro risultati.

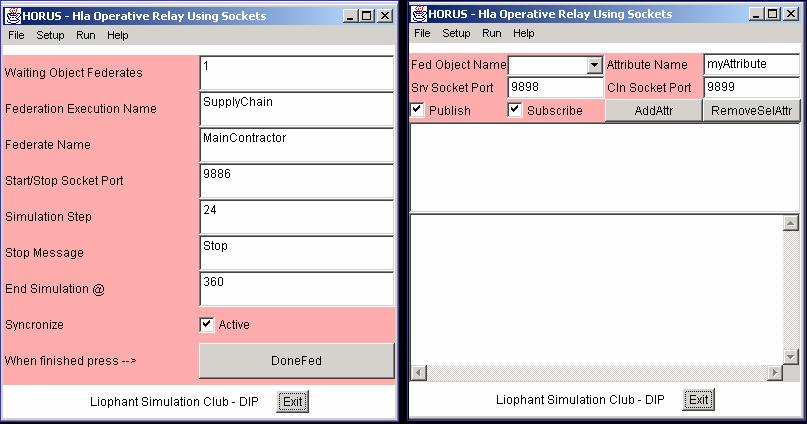

I limiti sperimentati nell’integrazione HLA di OSIRIS hanno comunque indirizzato a sospendere ulteriori sviluppi in questo senso a favore della costruzioni di sistemi di integrazione JAVA multipurpose (i.e. HORUS descritto nel seguito).

Aggancio ad ERP tipo SAP/3, BAAN, JD Edwards OSIRIS

Data la complessità funzionale dei sistemi transazionali nel caso di integrazione con OSIRIS si e’ deciso di estendere la parametrizzazione dei modelli in modo da garantire un esteso caricamento da file ASCII della configurazione; questo approccio ha consentito di lasciare in modo semplice ed efficace la possibilità di integrazione con ERP a fronte di programmi di interfaccia; detto sistema e’ stato sperimentato attualmente sia con sistemi custom di nuova generazione che, quantomeno in via preliminare con sistemi ERP presso alcuni dei case study in esame.

Convalida delle capacità di Generalizzazione di OSIRIS sul Caso Piaggio AeroIndustries

A seguito di alcuni meeting avuti in Piaggio (stabilimento di Finale ing.Maurizio Troya e ing.Gianpietro Ciravegna) sono emerse alcuni fatti, noti, che possono essere nel seguito brevemente riassunti: le previsioni di vendita per i velivoli P180 sono di 15 velivoli per l’anno 2000 e di 25 per il 2001. Il suddetto velivolo è composto da circa 15,000 pezzi, pezzi che sono costruiti o completati nella sede di Finale per una parte consistente. La produzione di Finale Ligure può essere articolata seconda una suddivisione data dal 35-40% per la produzione Falcon (main contractor Alenia), 20-50% P-180 (main contractor Finale Genova), 15-30% per motoristica e revisioni (suddivisione variabile nel corso del 2000/2001). Lo stabilimento conta un organico di 1250 persone tra diretti ed indiretti. Il fatturato, ha visto negli ultimi due anni un incremento del 70-80% con un passaggio da 140 Mld del 1999 agli attuali 230 Mld. Di questo, cospicua quota, è rappresentata dalla produzione del P-180.

La produzione di Finale Ligure è articolata su circa 9,000 part number di cui per esigenze di modellistica (shell OSIRIS) si focalizzeranno sui 1000 particolari critici. I 1000 part number considerati, completamente tempificati, sono sostanzialmente tutte quelle operazioni manuali che richiedono una schedulazione ed una simulazione. Il P-180 viene assemblato nello stabilimento di Genova, dove, la presenza di numerosi scali di assemblaggio permette la composizione dell’intero veicolo a partire da sottoassiemi di livello 1.

Osiris ha acquisito le informazioni per il modello di produzione dal sistema informativo utilizzato in Piaggio

Si ritiene utile, in questa breve nota, descrivere sommariamente il sistema informativo aziendale utilizzato all’interno dei due stabilimenti, rispettivamente, Genova e Finale Ligure. Il sistema informativo, basato su architettura IBM 2030/OS390, compie oggi 25 anni ed è stato completamente realizzato all’interno dell’azienda ed utilizza conseguentemente un formato dei dati proprietario, esiste oggi un progetto di implementazione di un moderno sistema ERP (probabilmente SAP R/3). Il sistema è in grado di gestire un database di tipo gerarchico denominato IMS, ma ha la possibilità di esportare dati in formato DB2 così da poterlo utilizzare con un driver SQL. In realtà, come spesso accade in questi casi, dalla teoria alla pratica il passo è lungo ed il processo di estrazione e filtraggio dei dati richiede un primo ed obbligatorio step da parte dell’ufficio sistemi informativi che scrive le opportune queries di interrogazione basandosi su quanto richiesto e ovviamente sul trace record. In sintesi il processo è identificabile in 2 passi: interrogazione dell’MVS e trasferimento delle informazioni su stazione remota via FTP del file di testo formato DB2.

I dati impiegati da OSIRIS possono essere brevemente riassunti come segue: diagrammi flussi logistici, diagramma del processo produttivo, lista part number, lista dei processi e dei tempi (cicli tecnologici), lista macchine (CDC) capacità produttive e flessibilità, gradi di libertà sul sistema quali outsourcing, turnazione, lavoro interinale, condivisione capacità produttive con altre produzioni.

Il modello sviluppato con OSIRIS e’ stato convalidato sui dati disponibili evidenziando prestazioni soddisfacenti; le valutazioni relative al carico dei magazzini in funzione dello sviluppo di produzione legato al P180 hanno evidenziato la necessità di procedere nell’analisi della supply chain.

Il sistema di integrazione ERP consentirà di acquisire i dati esportabili tramite transazioni dal nuovo ERP e di mantenere up-to-date la simulazione.

A seguito di questa esperienza si e’ potuta verificare la flessibilità e la capacità di generalizzazione assunta dal simulatore OSIRIS a seguito degli interventi legati a questo progetto; tuttavia la capacità di integrarsi in federazione HLA cosi’ come la velocità di esecuzione del modello e la complessità di sistema affrontabile hanno fatto preferire proseguire con altre linee applicative in parallelo piu’ efficaci nello sviluppo di federazioni di simulatori..

DPGI, Napoli

Preliminarmente alla fase di sviluppo vero e proprio del modello di simulazione si è proceduto ad una valutazione del software da adottare. Tale fase ha tenuto conto delle caratteristiche fisiche e logiche del sistema da modellizzare e delle caratteristiche tecniche che si intendeva conferire al modello stesso di simulazione.

Il problema di sincronizzazione del tempo simulato, infine,

è stato risolto mediante l’utilizzo di un blocco VBA, periodicamente

eseguito all’interno del modello, che interrompe l’esecuzione della simulazione

fino all’arrivo su una delle porte socket di un messaggio per il prossimo

appuntamento. L’insieme delle funzionalità descritte hanno consentito

la corretta integrazione in ambiente HLA.

Simulatori Ibridi

DIMEG; Bari

Il ricorso alla modellizzazione ibrida di sistemi produttivi, ossia alla integrazione ed interazione di modelli di programmazione matematica e di simulazione ha consentito di determinare pianificazioni aggregate della produzione rispondenti a predeterminati obiettivi tecnici ed economici e di valutare la fattibilità di tali piani attraverso modelli di simulazione.

I modelli ibridi realizzati sono costituiti da due moduli fondamentali interagenti in ambiente VBA. Un primo modulo provvede alla determinazione della dimensione dei lotti di produzione ed al loro sequenziamento risolvendo un problema di "Lot Sizing and Scheduling" multiprodotto, a capacità produttiva limitata, con l’obiettivo di ottimizzare una funzione economica dipendente da costi di produzione, costi di setup e costi di immagazzinamento. Il loading del sistema è simulato da un simulatore (secondo modulo) che considera tutte le specificità del sistema produttivo indagato fra le quali: i tempi di guasto e di riparazione, tempi di setup stocasticamente variabili e dipendenti dalla sequenza dei lotti di produzione. Il simulatore fornisce di ritorno allo schedulatore informazioni più affidabili sui tempi medi di setup e sulla capacità effettiva dei centri di lavoro. Queste informazioni consentono di rielaborare un nuovo e più affidabile piano di produzione. La procedura iterativa si arresta sulla base di predefiniti criteri di convergenza sulle prestazioni del sistema produttivo.

La modellizzazione è stata applicata a casi industriali in piena scala. Si tratta della produzione di componenti di sistemi frenanti per autovetture prodotti negli stabilimenti di Bari, Crema e Offanengo. Inizialmente, la modellizzazione ha interessato un singolo sito di produzione (il sito di Bari) al fine di testarne le capacità ed i limiti. Successivamente essa è stata estesa alla intera catena produttiva .

L’approccio ibrido è stato adottato anche per l’allocazione ottimale delle risorse di produzione di una unità produttiva facente parte di una supply chain. Dopo aver indagato i modelli di allocazione ottimale delle risorse disponibili in letteratura, è stato realizzato un modello ibrido che riproduce il comportamento della singola unità produttiva.

La cooperazione con le importanti realtà produttive oggetto di studio ha messo in evidenza il bisogno di disporre di strumenti metodologici ad un tempo semplici ed in grado di rappresentare problemi di interesse industriale.

Per questa ragione le modellizzazioni ibride "locali" e "globali" della catena sono state realizzate attraverso strumenti informatici di larga diffusione e basso costo, quali, come già detto, il solver LINDO® ed il package ARENA®. Si tratta di strumenti "user friendly" molto orientati all’uso integrato anche da parte di non esperti di modellistica e, pertanto, di agevole applicazione ed uso in ambito industriale.

Risultati ottenuti:

Simulatori Generati Automaticamente

DEF, Firenze

La maturità raggiunta dagli strumenti e dagli ambienti di simulazione oggi disponibili sul mercato, anche per i vantaggi derivanti dall’introduzione della programmazione orientata agli oggetti, nonché le attuali architetture run-time di tali strumenti, che consentono lo scambio dati con ambienti esterni (in modalità ODBC per l’acceso ai dati, OLE/DDE per lo scambio di oggetti, tramite interfacce specifiche per la lettura-scrittura di file, tramite l’apertura di socket e l’uso di protocolli EDI, MAPI, X400/X500 per lo scambio di messaggi e dati su rete LAN/WAN/internet), oltre che l’introduzione di potenzialità di tipo controlling outside e/o programming inside, fanno della simulazione uno strumento estremamente potente nell’ambito del PP&C, per effettuare analisi di scenario in tempo reale, per la verifica di alternative di scheduling e dispatching, e per quant’altro richiesto dai practitioner del citato contesto.

L’integrazione con gli strumenti tipici dell’area gestionale (come ad esempio, software per la schedulazione, ERP) ha evidenziato ancor più il problema di rendere tali applicazioni alla portata degli utenti dei suddetti sistemi. Per questo fine, l’ostacolo principale è certamente costituito dalla difficoltà insita nel modelling del sistema produttivo e delle sue strutture ed infrastrutture, nella formalizzazione dei suoi vincoli e delle logiche di funzionamento e controllo.

L’idea alla base della ricerca è quella di sviluppare un approccio formale per il modeling dei sistemi produttivi, che consenta di generare automaticamente un modello di simulazione a partire da una rappresentazione completa degli oggetti appartenenti al sistema e delle loro relazioni, oltre che da un insieme di dati strutturato che descriva il loro stato corrente.

Per questo fine, seguendo il formalismo UML, sono state sviluppate delle view per identificare le classi di oggetti necessarie al fine di rappresentare un generico sistema di tipo manifatturiero, con riferimento alle strutture produttive (macchine, operatori, magazzini e buffer interoperazionali, mezzi di movimentazione) e loro aggregazioni (reparti, celle tecnologiche, linee di fabbricazione e/o assemblaggio).

L’oggetto della produzione è stato rappresentato tramite mappatura delle informazioni elementari che legano il prodotto al processo produttivo (progettazione, ingegnerizzazione e fabbricazione), identificando nella distinta base, nelle process sheets e nelle routing sheets gli strumenti da utilizzare al fine della sua descrizione.

Infine, l’impegno è stato rivolto alla classificazione

dei modelli di riferimento impiegati nel PP&C (dalla principale letteratura

sull’argomento, e dalle esperienze maturate in ambito industriale), ovvero

logiche di tipo push puro (MRP e Load-Oriented Manufacturing Control),

pull puro (Kanban e Order Point), logiche ibride (combinazioni delle precedenti).

Schema UML delle classi strutturali.

Schema UML delle classi tecnologiche.

L’analisi condotta ha consentito di identificare le regole generali secondo cui può avvenire lo scambio di informazioni tra sistema di controllo e risorse produttive, ed ha permesso di costruire una struttura di riferimento per la successiva fase di implementazione.

Prima di procedere con l’affinamento della struttura (definizione di proprietà e metodi aggiuntivi per caratterizzazioni spinte, estensione a modelli PP&C non contemplati in prima istanza), è stato ritenuto di fondamentale importanza verificare la funzionalità e la robustezza dell’approccio ipotizzato. Per questo, grazie all’esperienza sviluppata nel campo della simulazione e della programmazione orientata agli oggetti, è stato fatto un primo test della struttura, utilizzando deliberatamente un simulatore disponibile in commercio. La scelta è caduta sul simulatore ad oggetti SiMPLE++, dove sono state implementate le principali classi di oggetti precedentemente formalizzate per la descrizione delle strutture fisiche e di quelle tecnologiche, ed è stata portata a termine l’implementazione di alcuni modelli gestionali (MRP e kanban a doppio cartellino). Si è così ottenuto, come risultato preliminare, la generazione automatica (da una struttura di dati esterna al simulatore) di un modello ready-to-run di un sistema produttivo, opportunamente utilizzato come test bed.

Class Diagram di un sistema gestito con logica Load-Oriented

La logica con cui ciò può avvenire è di seguito riassunta: tutte le classi necessarie a rappresentare il sistema sono presenti nella libreria del simulatore, e tramite una serie di script vengono istanziati e caratterizzati solamente gli oggetti che trovano descrizione nella struttura dati.

I vantaggi che derivano da questo approccio sono di immediata comprensione: il modello/i modelli così generati non necessitano di manutenzione, in quanto immediatamente aggiornabili (massima reusability) eseguendo ex-novo (ad esempio, in seguito all’introduzione di una nuova machina, o di un nuovo prodotto) la procedura di generazione automatica del modello, a partire da un set di dati aggiornato o modificato. Questo può consentire l’utilizzo del simulatore come strumento di analisi on-line, ad esempio per la verifica dell’Available-To-Promise, o per la validazione di un programma di produzione generato, in modo statico, da uno schedualtore.